西游记大闹天宫内容概括

代码和Demo地址:https://github.com/dvlab-research/LongLoRA

论文地址:https://arxiv.org/pdf/2309.12307.pdf

中途迷失、模型偷懒、上下文越长大模型越笨......如果体验过大语言模型产品,用户多少会对文本输入长度带来的限制有所感触,比如当想和大模型讨论一些稍长的内容,需要拆分输入,而前面输入的要点,很快就会被大模型忘记。

这是典型的大语言模型对话缺陷!就像先天有注意力缺陷的儿童,难以专注看完一本新书。而缺陷的关键,在于模型缺乏长文本处理能力。这个局面如今被打破。

近日,贾佳亚团队联合MIT发布的新技术和新模型悄然登上各大开源网站的热榜:hugging face热榜第一、paperwithcode热度第一,Github全部python项目热度第五、github stars一周内破千,Twitter上的相关技术帖子浏览量近18万......

github stars 已达1.3k

github stars 已达1.3k

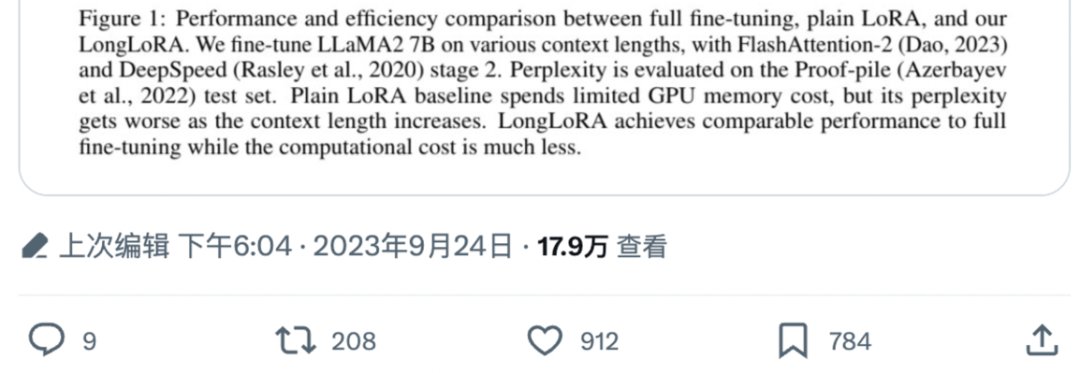

Twitter上的相关技术帖子浏览量近18万

这项名为LongLoRA的技术实用但却简单得令人惊讶:只需两行代码、一台8卡A100机器,便可将7B模型的文本长度拓展到100k tokens,70B模型的文本长度拓展到32k tokens;同时,该研究团队还发布了首个拥有70B参数量的长文本对话大语言模型LongAlpaca。

全球首个70B长文本大语言模型发布

LongLoRA的提出,让全球大语言模型的对话缺陷第一次得到解决,自此,几十页的论文、几百页的报告、鸿篇巨制不再成为大模型盲区。

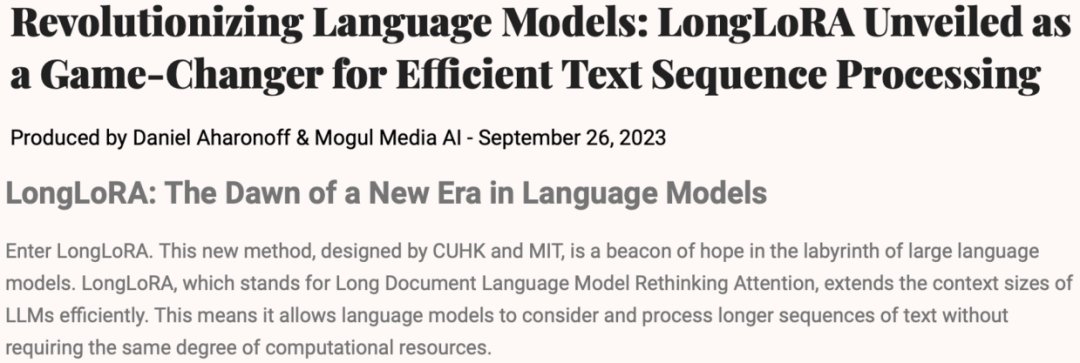

对此,有专业人士激动地表示,LongLoRA是大语言模型迷宫中的希望之灯!它代表着业界对长文本大语言模型的重新思考和关注,有效扩展了大语言模型的上下文窗口,允许模型考虑和处理较长的文本序列,是大语言模型的革新性发明。

除了技术革新外,大语言模型处理长文本问题的一大难点还在于缺少公开的长文本对话数据。

为此,研究团队特意收集了9k条长文本问答语料对,包含针对名著、论文、深度报道甚至财务报表的各类问答。

光会回答长问题还不够,该团队又挑选了3k的短问答语料与9K的长问答语料混合训练,让长文本大模型同时具备短文本对话能力。这个完整的数据集被称为LongAlpaca-12k,目前已经开源。

在LongAlpaca-12k数据集基础上,研究团队对不同参数大小7B、13B、70B进行了训练和评测,开源模型包括LongAlpaca-7B, LongAlpaca-13B和LongAlpaca-70B。

看小说、改论文、指点经济堪称全能王

话不多说,盲选几个demo,一起看看应用了LongLoRA技术叠加12K问答语料的大模型LongAlpaca效果。

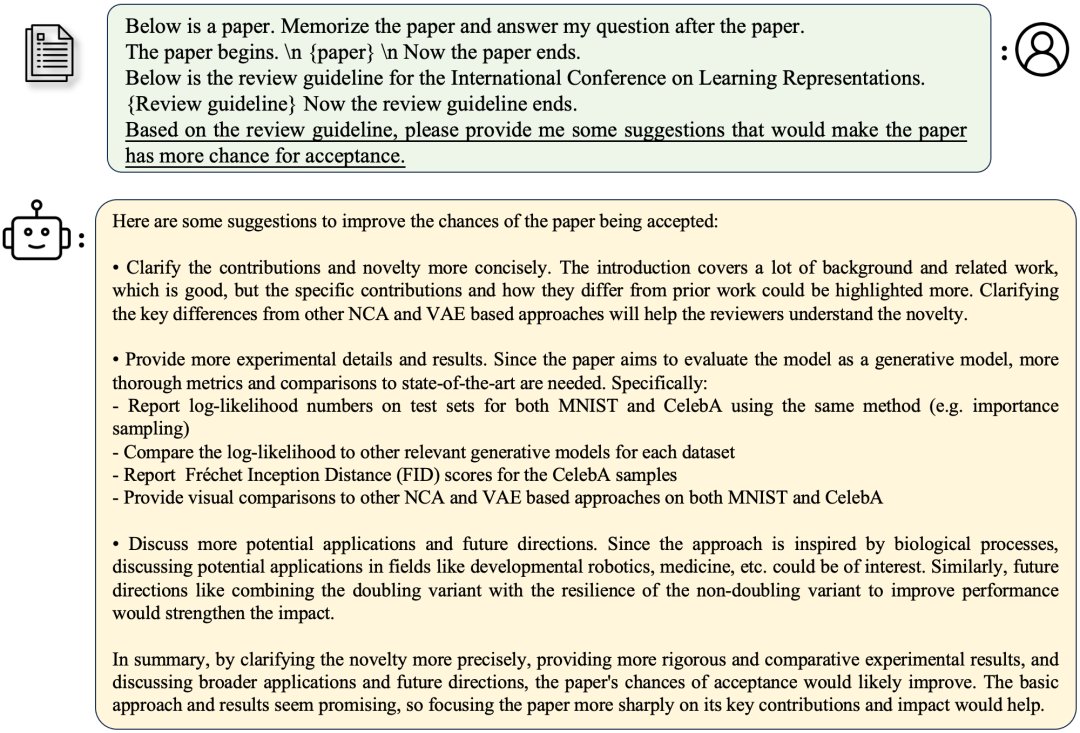

让系统新读一篇论文,并根据ICLR的审查指南,对其提出修改意见,从而提升该论文的接收率。LongAlpaca的意见是:通过更精确地阐明新颖性,提供更严格和更有对比性的实验结果(包括具体的数据集和指标)、更广泛的应用和未来发展方向,重点呈现关键贡献和影响,论文被接受的机会将得到提高。

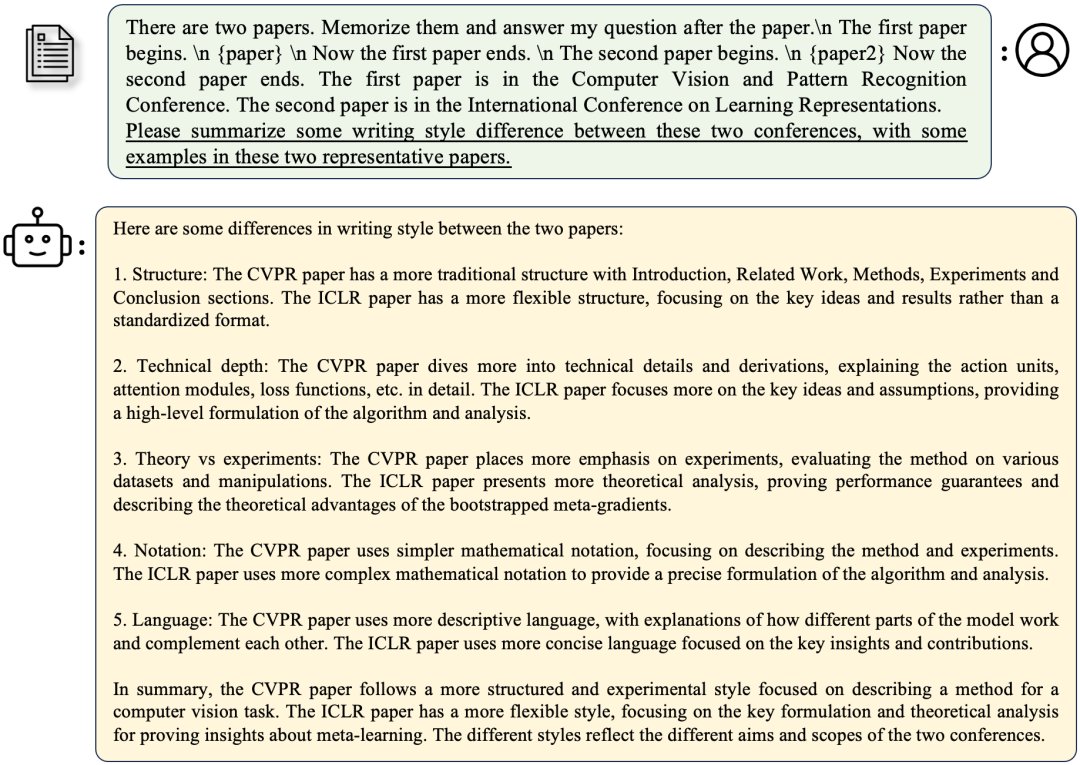

现在,让系统读两篇新的不同的论文,让LongAlpaca概括ICLR和CVPR两个会议之间的风格区别。LongAlpaca总结认为,CVPR论文倾向更具结构性和实验性的风格,专注于实用性和技术性。而ICLR的论文风格更加灵活,侧重关键的理论分析和数学推导,而非标准格式。

可以看出,经过训练的LongAlpaca模型已经可以很轻松地接受新的长篇学术论文,在学术相关问题的回答上相当精准。

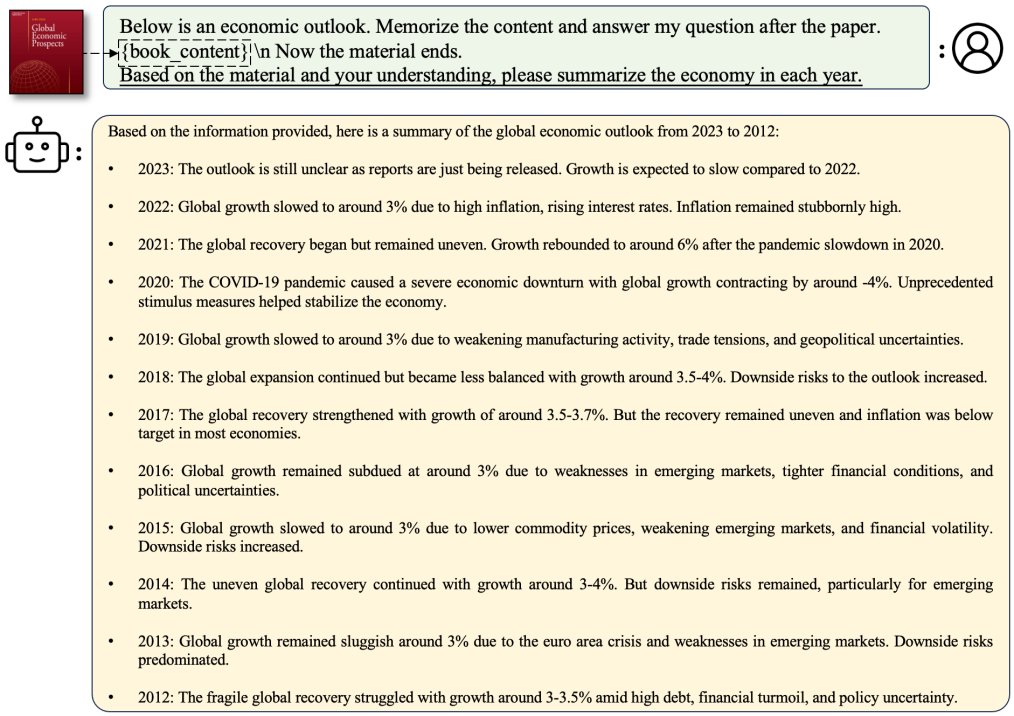

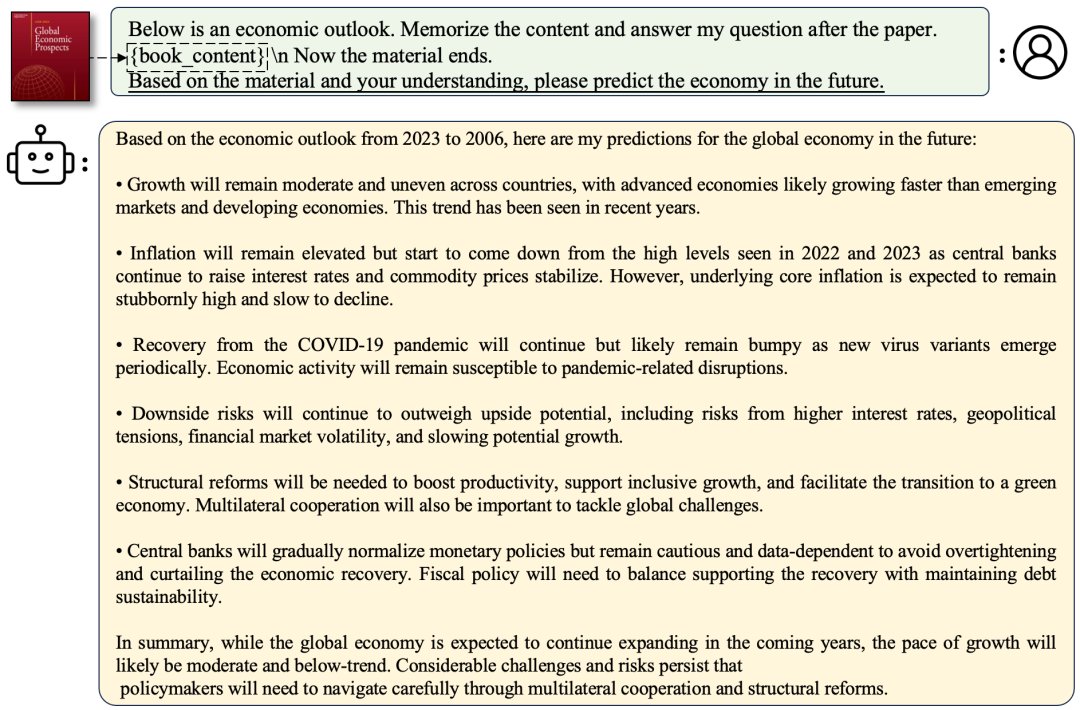

接下来,再看看LongAlpaca模型在颇高阅读和理解门槛的经济领域的解读表现。

根据国际货币基金组织从2012年到2023年的全球经济展望的概述合集,对经济形势进行逐年总结以及对未来经济趋势进行预测。LongAlpaca告诉我们,2023年全球经济形势不明朗,跟2022年相比,增长预计放缓;未来几年,全球经济扩张速度偏温和并将低于预期,而地缘政治紧张、金融市场波动等大的挑战依然存在,需通过多边合作和结构性改革小心应对。

LongAlpaca还可以读新的长篇小说,读完后对内容进行分析。下面选取的对比模型是13B参数的LongAlpaca和Llama2,且看各自表现。

名著《西游记》中,为什么孙悟空在大闹天宫时很厉害,但取 经路上却屡屡受挫?LongAlpaca 给出了5点原因,大概可总结为 “孙悟空的不成熟、强大的对手、力量的限制、敌人的欺骗、最初 缺少同伴等因素导致了他在旅途中的失败。但随着时间推移,他获 得了智慧、经验和战友,使他最终战胜了最强大的敌人。”

而 Llama2 的回答较为简单。“虽然他确实大闹天宫,但说他代表着不败的力量并不一定准确。事实上,他最终在西游记中被强大的唐三藏打败。”Llama2没有给出正确答案,并且还提出需要更多的内容信息。

这一次让系统新读一次《三体》,然后问第一部中,叶文洁为什么要联系外星人,而后期又为什么后悔?LongAlpaca认为,叶文洁最初接触外星人是出于理想主义和复仇,但随着时间的推移,她对人类的看法发生了变化,意识到自己可能给全人类带来的危险,她的悔恨与日俱增。回答得十分清晰。

而Llama2的回答则是,“通过与外星人的互动,她希望能更深入地了解宇宙的本质,以及自己在宇宙中的位置。叶文洁逐渐意识到,外星人和他们的技术并不能解决她的问题。”回答笼统,之后开始对小说整体进行评论,答非所问。

从模型给出的答案可发现,一些模型如Llama2 [2] 可能在预训练过程中见过相关小说,但如果在提问时进行仅根据小说题目进行短文本提问的话,回答并不理想。

两个模型的回答对比,高下立见。LongAlpaca改学术论文、点评全球经济大势和读小说,都是一把好手,完胜 Llama2。

两行代码和三个关键结论

Llama2可以说是 AI 社区内最强大的开源大模型之一,行业位置领先,LongAlpaca居然可以完胜。其背后的LongLoRA技术成功引起网友们的注意,到底是怎么做到的?

原来大语言模型对长文本处理过程中,计算量的主要开销集中在自注意力机制(self-attention),其开销随着文本长度成平方次地增加。

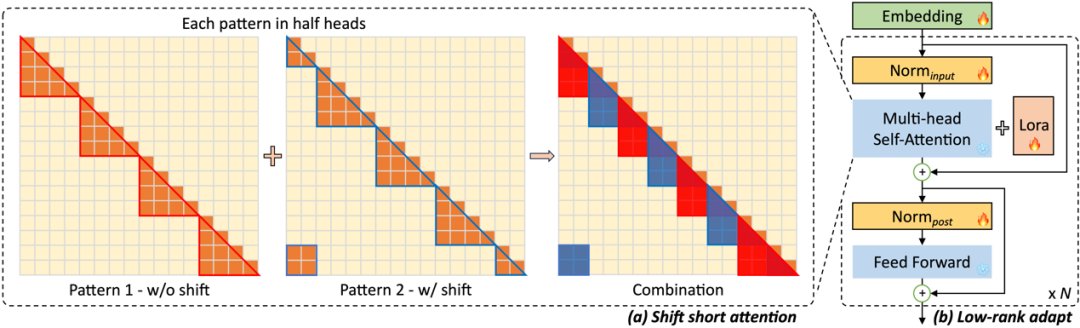

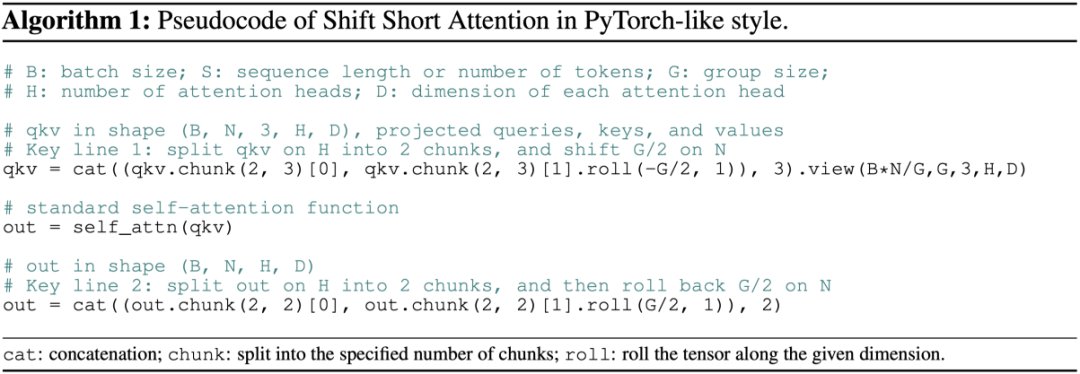

针对这个问题,研究团队提出LongLoRA技术,并用分组和偏移的方式来对全局自注意力机制进行模拟。

简单来说,就是将长文本对应的tokens拆分成不同的组,在每组内部做自注意力计算,而分组的方式在不同注意力头 (attention head) 上有所偏移。这样的方式既可以大幅度节约计算量,又可以维持全局感受野的传递。

而这个实现方法也非常简洁,仅两行代码即可完成!

LongLoRA还探索了低秩训练的方式。原有的低秩训练方式,如LoRA [5],无法在文本长度迁移上取得良好的效果。而LongLoRA在低秩训练的基础上,引入嵌入层 (Embedding layer和 Normalization layers) 进行微调,从而达到可以和全参数微调 (Full fine-tune) 逼近的效果。

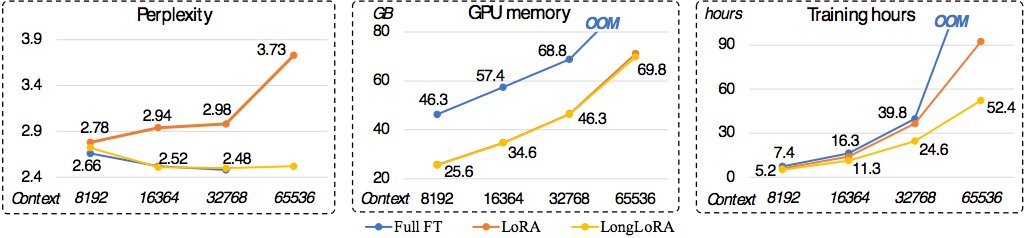

进行不同长度文本扩展和训练时,LongLoRA、LoRA和全参数微调不同技术的具体效果如何,可以参考三个维度表现:

在Perplexity-困惑度上,原有LoRA方法的性能在不断恶化,而LongLoRA和全参数微调都能在各种文本长度下维持很好的效果;

在显存消耗上,相比于全参数微调,LongLoRA和原有LoRA都有大幅度的节省。例如,对于8k长度的模型训练,相比于全参数微调,LongLoRA将显存消耗从46.3GB降低到25.6GB;

在训练时间上,对于64k长度的模型训练,相比于常规LoRA,LongLoRA将训练时间从90~100小时左右降低到52.4小时,而全参数微调超过1000小时。

极简的训练方法、极少的计算资源和时间消耗,以及极佳的准确性,令LongLoRA大规模推广成为可能。目前,相关技术与模型已全部开源,感兴趣的用户们可以自己部署感受。

值得一提的是,这是贾佳亚团队继8月9日发布的“可以分割一切”的多模态大模型 LISA 后的又一力作。相距不过短短两个月,不得不说,这研究速度和能力跟LongLoRA一样惊人。

参考文献

[1] LLaMA team. Llama: Open and efficient foundation language models. Arxiv, 2302.13971, 2023a.

[2] Llama2 team. Llama 2: Open foundation and fine-tuned chat models. Arxiv, 2307.09288, 2023b.

[3] Shouyuan Chen, Sherman Wong, Liangjian Chen, and Yuandong Tian. Extending context window of large language models via positional interpolation. Arxiv, 2306.15595, 2023.

[4] Szymon Tworkowski, Konrad Staniszewski, Mikolaj Pacek, Yuhuai Wu, Henryk Michalewski, and Piotr Milos. Focused transformer: Contrastive training for context scaling. Arxiv, 2307.03170, 2023.

[5] Edward J. Hu, Yelong Shen, Phillip Wallis, Zeyuan Allen-Zhu, Yuanzhi Li, Shean Wang, Lu Wang, and Weizhu Chen. Lora: Low-rank adaptation of large language models. In ICLR, 2022.

雷峰网

","gnid":"9d31049e1314b4538","img_data":[{"flag":2,"img":[{"desc":"","height":"420","title":"","url":"https://p0.ssl.img.360kuai.com/t0178cafb03ce373a2b.jpg","width":"1014"},{"desc":"","height":"373","title":"","url":"https://p0.ssl.img.360kuai.com/t011eab1b4fdba75e20.jpg","width":"1080"},{"desc":"","height":"363","title":"","url":"https://p0.ssl.img.360kuai.com/t01dd3fb57630b3f868.jpg","width":"1080"},{"desc":"","height":"733","title":"","url":"https://p0.ssl.img.360kuai.com/t01b9d544af4006df62.jpg","width":"1080"},{"desc":"","height":"765","title":"","url":"https://p0.ssl.img.360kuai.com/t013d1f6cae45ebfa13.jpg","width":"1080"},{"desc":"","height":"716","title":"","url":"https://p0.ssl.img.360kuai.com/t01367a62137ee4b9ad.jpg","width":"1014"},{"desc":"","height":"710","title":"","url":"https://p0.ssl.img.360kuai.com/t015ba54fc82c7ac26b.jpg","width":"1080"},{"desc":"","height":"1049","title":"","url":"https://p0.ssl.img.360kuai.com/t0108f77754d326bfc3.jpg","width":"1009"},{"desc":"","height":"1034","title":"","url":"https://p0.ssl.img.360kuai.com/t01638efa3b8993d160.jpg","width":"1058"},{"desc":"","height":"328","title":"","url":"https://p0.ssl.img.360kuai.com/t011480604b1f95358e.jpg","width":"1080"},{"desc":"","height":"374","title":"","url":"https://p0.ssl.img.360kuai.com/t01954a603aa0394ba0.jpg","width":"1080"},{"desc":"","height":"238","title":"","url":"https://p0.ssl.img.360kuai.com/t010d6b1865e94f4467.jpg","width":"1024"}]}],"original":0,"pat":"art_src_1,fts0,sts0","powerby":"pika","pub_time":1696824629000,"pure":"","rawurl":"http://zm.news.so.com/ae12cc1ceb640d7774c5364f2a0fe03f","redirect":0,"rptid":"6d56455139a6736a","rss_ext":[],"s":"t","src":"雷峰网","tag":[],"title":"两行代码解决大语言模型对话局限! 港中文贾佳亚团队联合MIT发布超长文本扩展技术

路盾炒4458西游记之大闹天宫故事梗概200字原创 -

丁峡家15530254861 ______ 悟空在第324岁,因阳寿已尽而大闹地府,销毁生死簿,返回人间.阎王再复上报天庭,玉皇大帝欲捉拿悟空,太白金星建议招安.孙悟空被召上天宫,被骗封为弼马温,15日后知道原来这官只不过是个马夫,大怒,打出南天门.回花果山时,凡间已经过了15年.独角鬼王前来投奔,建议悟空自封“齐天大圣”,孙悟空在此时广交朋友,结拜七兄弟. 玉皇大帝知道孙悟空反下天宫,大怒,命李天王派兵镇压,孙悟空打败巨灵神,哪吒三太子,天宫被迫封其为齐天大圣.不料当上大圣,孙悟空反而偷吃蟠桃、偷盗仙酒,玉帝震怒,命李天王再率十万天兵天将带十八架天罗地网,去拿下妖猴,孙悟空打败九曜恶星,四大天王,使分身术战败十万天兵,因为此战,孙悟空名扬天下.

路盾炒4458急!!!西游记的大闹天宫的概括,要自己的话!不要复制来的!急!!!赏50分!! -

丁峡家15530254861 ______ 孙悟空学了一身本领,因太白金星建议,玉帝招悟空上天当了一个官——弼马温,天上众仙讥笑他官小看不起他.一气之下把马放了,返回花果山,竖起齐天大圣旗帜,玉帝恼火,派遣天王李靖收服,被悟空大败.太白金星再次建议招安,就封悟空有名无实的“齐天大圣”,看王母的蟠桃园.蟠桃会召开在即,众仙都去,没有请悟空,悟空偷偷跑进瑶池,把瑶池的玉液琼浆喝了干净,各种美食全吃了,闹的一片狼藉,又跑到太上老君哪里吃了仙丹.玉帝大怒,大肆正压,后被杨二郎擒住,各种刑法对悟空斗无效,最后让太上老君炼丹炉里炼,反而连成悟空的火眼金睛.悟空打翻炼丹炉,吓得玉帝只能请如来,如来用计将悟空骗压在五指山下…… 不知道这样可否

路盾炒4458用一句话概括孙悟空大闹天宫故事情节这是一个题.与玉皇大帝争夺宝位. -

丁峡家15530254861 ______[答案] 孙悟空因不满玉皇大帝,于是大闹天宫,最终惹怒玉帝,玉帝派天兵天将围剿花果山

路盾炒4458西游记大闹天宫的故事概括最多三句话 -

丁峡家15530254861 ______[答案] 猴王大战十万兵 一招不慎二郎擒 老君炉内炼金睛

路盾炒4458《大闹天宫》30字概括是什么? -

丁峡家15530254861 ______ 《大闹天宫》30字概括是:孙悟空当年在天庭打理蟠桃园时,曾偷吃蟠桃,后来又大闹天宫. 主要内容:孙悟空在龙宫里大闹一场,拿到了如意金箍棒,结果被龙王告发,被他忽悠去了天庭.孙悟空得知自己的地位低下,于是回到了花果山,...

路盾炒4458<<西游记之大闹天宫>>的主要内容

丁峡家15530254861 ______ 电影讲述孙悟空(甄子丹 饰)曾跟菩提祖师修成七十二变,决心要成为神仙,但因青梅竹马的好友九尾狐(夏梓桐 饰)被杀害及误交牛魔王(郭富城 饰)而视天庭为敌.牛魔王为了让他深爱的妻子铁扇公主(陈乔恩 饰)和怀了三百年的爱子红孩儿重返天界,煽动孙悟空联手大闹天庭,最终迫使玉帝(周润发 饰)率领二郎神(何润东 饰)等众仙迎战,展开连场仙魔大战... 这个片子3D效果不错,推荐

路盾炒4458西游记的大闹天宫、三打白骨精、三借芭蕉扇的概括.200--300字左右!急1!赏100分! -

丁峡家15530254861 ______[答案] 孙悟空因蟠桃会没邀请他,便施计偷酒偷桃还偷吃老君的仙丹.玉皇多次派兵捉拿无果,遣二郎真君出战,争斗中孙被老君偷袭遭擒.因杀不了而将其入老君炉烧炼,逃出炉后闹得天宫鸡飞狗跳,后被如来施计压在五指山下.-------大闹天宫 师徒四人聚齐...

路盾炒4458西游记大闹天宫概括 -

丁峡家15530254861 ______ 孙悟空占山为王,被玉帝招安为弼马温,孙嫌官小,反出天庭,后玉帝招之为“齐天大圣”虚衔,又因蟠桃会未邀请之,再度反下天庭,后天庭败于其手下,最后请如来镇压了孙. 有点不精辟啊,罗嗦了点

路盾炒4458孙悟空大闹天宫 简介20字? -

丁峡家15530254861 ______ 《孙悟空大闹天宫》出自吴承恩撰写的《西游记》.《西游记》中,孙悟空去东海龙宫抢了金箍棒,又去地府强销生死簿.龙王、阎君去天庭告状,玉帝把孙悟空召入天庭,授他做弼马温.孙悟空嫌官小,打回花果山,自称“齐天大圣”.玉帝派天兵天将捉拿孙悟空,却没有成功,便让孙悟空管理蟠桃园.孙悟空因王母没请他去参加蟠桃宴便偷吃蟠桃,毁了王母的蟠桃宴,逃后又偷吃了太上老君的金丹后返回花果山.玉帝大怒再派李天王率天兵捉拿;观音菩萨举荐二郎真君助战;太上老君在旁使暗器帮助,最后悟空被擒.悟空被刀砍斧剁、火烧雷击,甚至置丹炉锻炼七七四十九日,依然无事,还在天宫大打出手.最后还是玉帝下令请来如来佛祖,才把孙悟空压在五行山下.