attention翻译成中文

作者 | 李水青编辑 | 心缘

智东西1月25日报道,昨日,岩山科技旗下创企岩芯数智(Rock AI)推出国内首个非Attention机制的大模型Yan,也是业内少有的非Transformer架构大模型。

岩芯数智CEO刘凡平介绍,Yan是一个通用大语言模型,拥有相较于同等参数Transformer的7倍训练效率、5倍推理吞吐、3倍记忆能力,同时支持CPU无损运行、低幻觉表达、100%支持私有化应用。

标准的Transformer架构模型在消费级显卡微调,难以达到大规模商业化的目标;训练至少花费数百万以上,对企业来说并不经济划算。刘凡平透露,基于Yan架构,仅需投入50万元的训练成本,就可以拥有百万参数级的大模型。Yan支持100%支持私有化部署,支持CPU服务器运行,能在端侧设备上流畅运行。

智东西与少数媒体对岩芯数智CEO刘凡平进行了采访。岩芯数智对标业内的什么大模型?Yan有什么优势和劣势?

刘凡平告诉智东西,Yan还没有真正对标谁,今天大家看到对比Transformer的一些数据是用Llama 2的数据进行的比较,能看到性能差异。团队对标的是底层技术架构,而不是某一产品。

优势和劣势方面,今天介绍的效果是通过大量实验验证测试出来的,它确实在训练效率、推理效率、记忆能力、幻觉表现了很强的优势,包括CPU上运行。团队自己从理论上(非应用层面)推导的劣势,可能在上百k超长文本上会有语义上的缺陷。

当下,业内同时出现了Mamba、RWKV等非Transformer架构的大模型。刘凡平说,参考Mamba与Llama 2对比的数据图表,Yan的数据比Mamba要好。

一、比Mamba数据好,效率7倍于Transformer

Attention机制,简单来说,是通过一种非线性的矩阵方式表达更多东西。在标准Attention机制下,计算复杂度较高,已经成为大模型领域的一大难题。

岩芯数智技术负责人杨华解读,Yan不采用Attention机制,也不采用RNN序列,而是建立一种线性的向量方式,将计算复杂度大幅降低,做到线性时间复杂度,还能做到常量的空间复杂度,从而提高大模型的性能和效果。

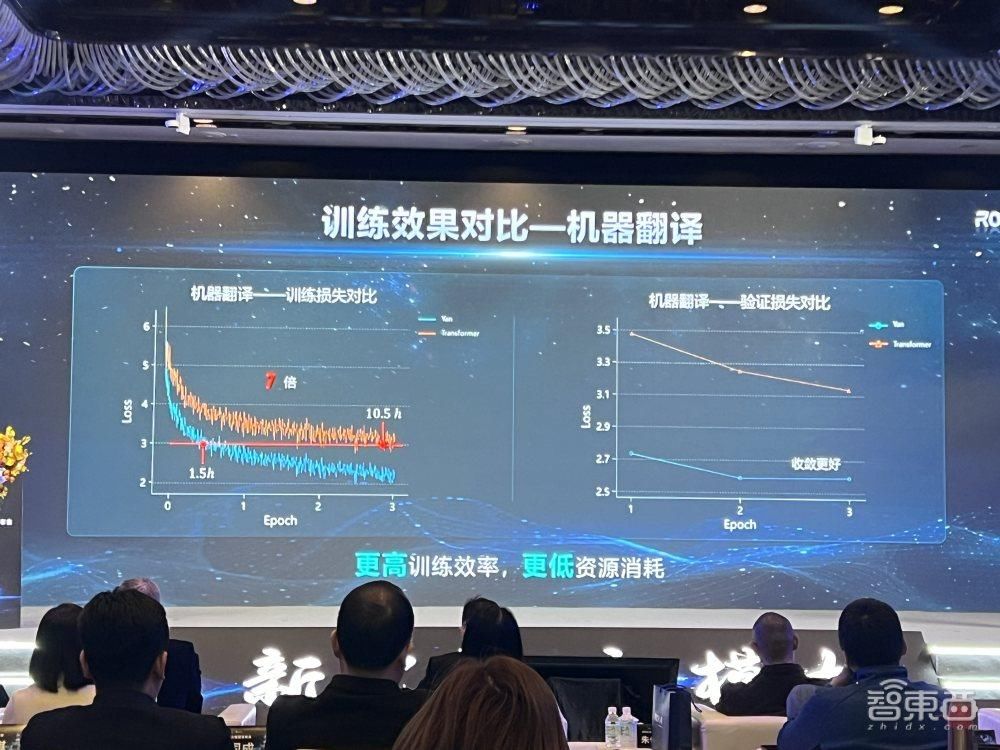

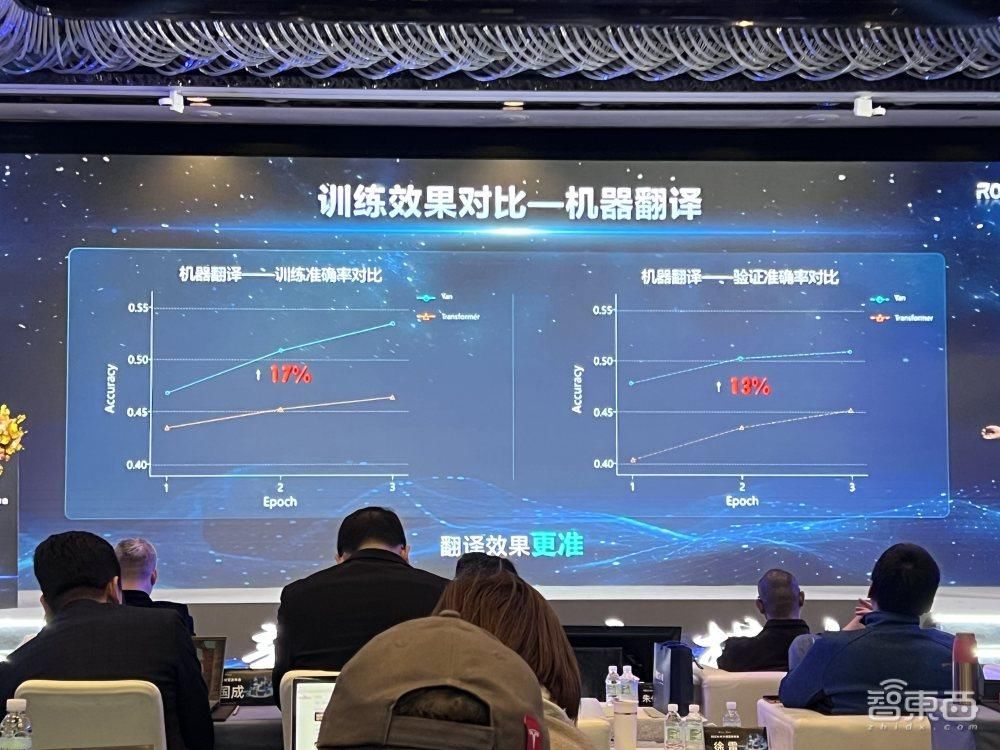

1、训练效果:预测准确率提高17%

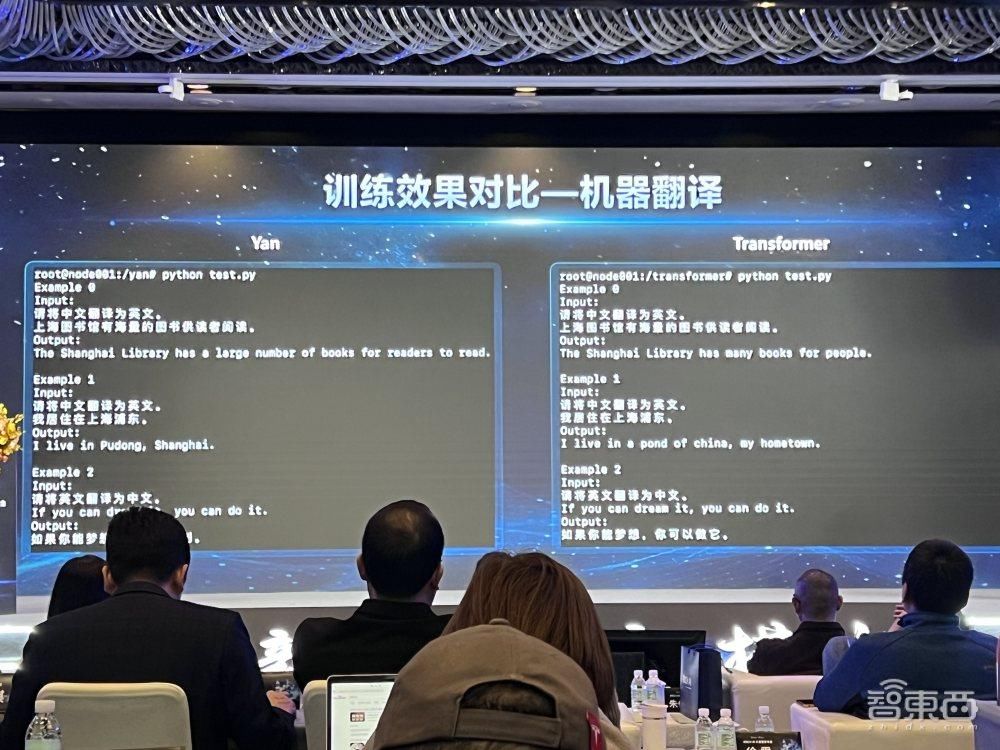

以机器翻译为例,对Yan与Transformer架构的表现对比,在训练集和验证集上,Yan的损失值都要低于Transformer。Yan的训练效率是Transformer的7倍,消耗的资源更低。

训练集上,Yan的预测准确率比Transformer高出17%,验证集上Yan要高出13%。

2、推理吞吐量:同资源下高于Transformer

在推理吞吐量对比方面,相同资源下,Yan的吞吐量都要高于相同情况下的Transformer,达到其5倍,能支持更多用户的并发使用。

3、推理资源消耗:支持更长序列,降低应用成本

当模型输出的Token从200增加到3000时,Transformer会出现显存不足,但Yan模型始终显存稳定。理论上可以实现无限长度的推理,应用成本更低。

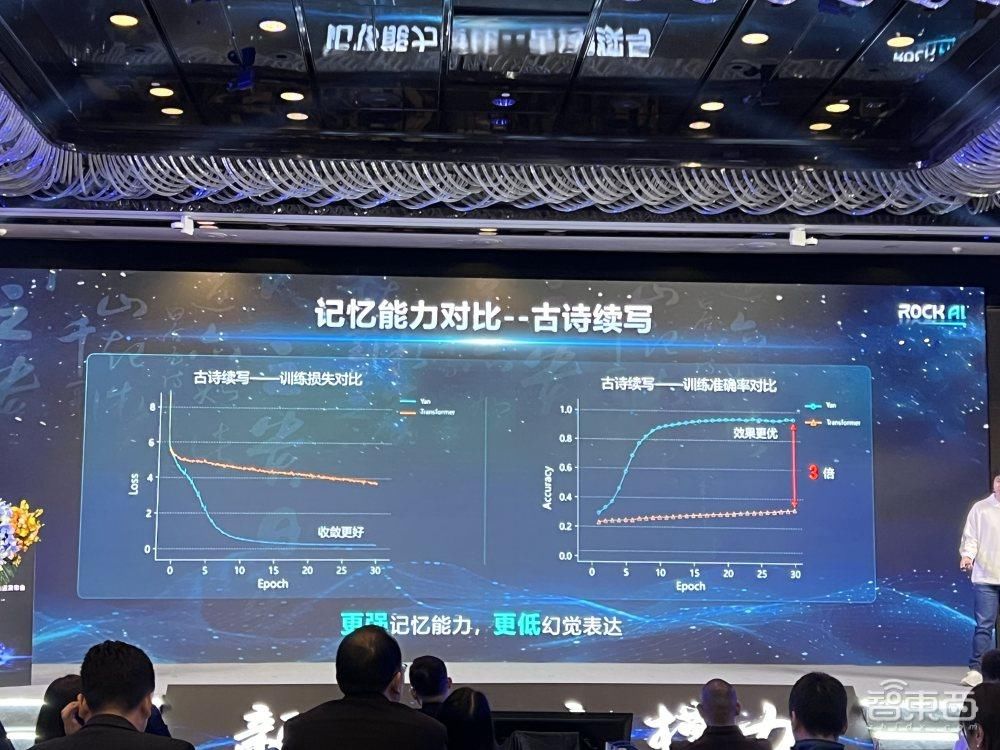

4、记忆能力:准确率为Transformer的3倍

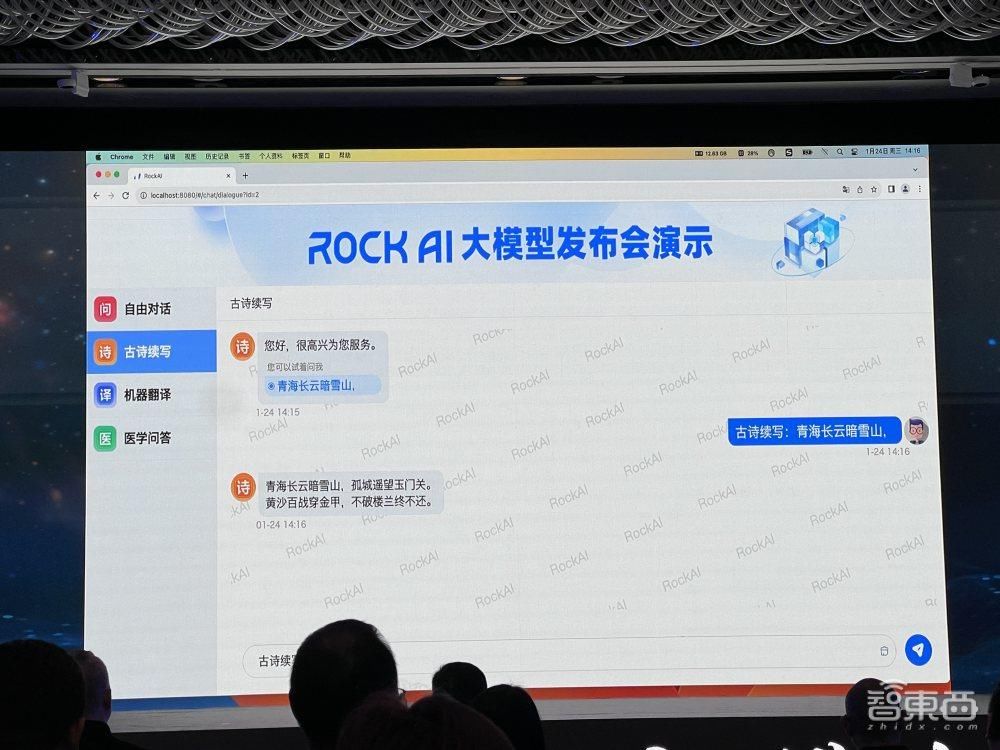

以古诗续写为例,对Yan与Transformer的记忆能力进行对比。训练集上Yan的准确率达到Transformer的3倍,记忆能力更强。

从以下三个例子看到,Transformer没有完成对训练数据的记忆,只记住了句式和字数;Yan则克服幻觉,依靠记忆进行了续写。

刘凡平说,Yan不是基于Llama、GPT、PaLM的套壳,不是基于其他Transformer架构大模型的二次预训练,不是基于开源模型的微调,而是其完全自主知识产权研发的新一代架构大模型。

二、现场演示四大能力,记忆力与逻辑兼顾

目前,Yan1.0推出1.3B、7B和48B三个版本参数规模的模型,并支持大于100B模型的训练。

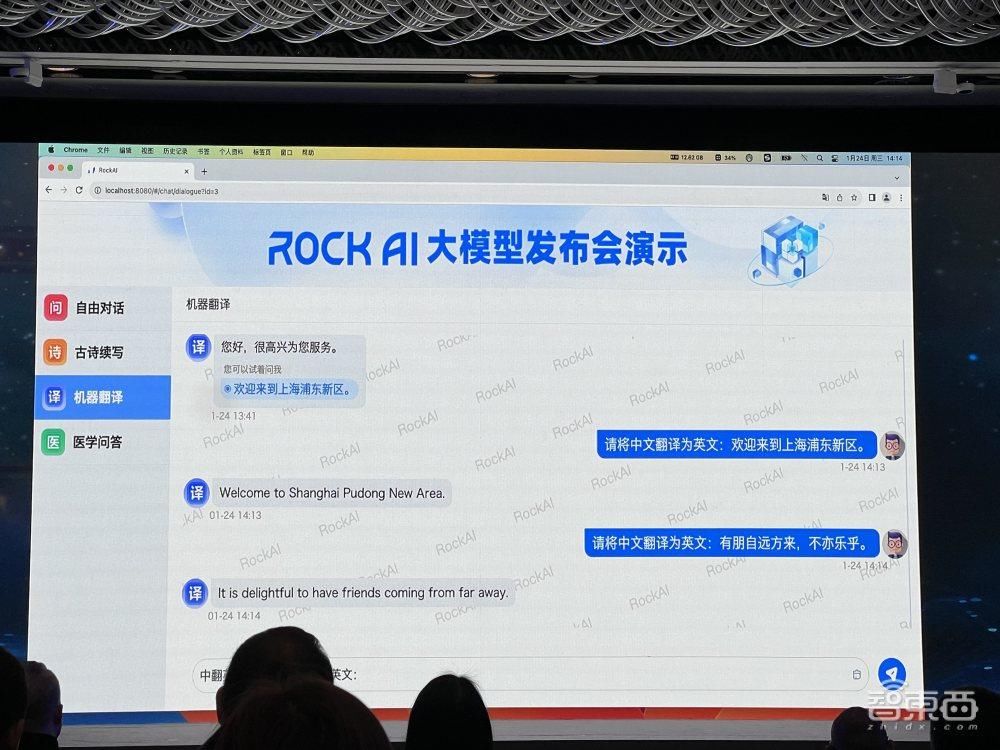

岩芯数智在现场对Yan1.0大模型进行了演示,通过一台笔记本电脑,本地内存使用维持在13G之内,实现模型运行。演示的内容涉及机器翻译、古诗续写、自由对话和医学问答四个方面。

1、机器翻译,比Transformer更地道

如下图所示,当输入“东方明珠是上海的经典建筑”,Yan1.0给出了准确翻译。由于机器翻译是Transformer的根,因此岩芯数智从这一根技术出发验证Yan1.0大模型的能力。

通过一个翻译示例看到,Yan将上海浦东翻译成一个地方,但Transformer没有识别出浦东这一地名,以为是一个Pond(池塘)。

2、古诗续写,提升记忆、降低幻觉

在故事续写能力方面,Yan1.0现场续写了“青海长云暗雪山”这句诗,展现了其记忆能力。Yan1.0的古诗续写不依赖网络搜索引擎和专家系统,而是靠自己的架构能力。对于实际应用来说,记忆能力可以帮大模型降低幻觉,从而更具有实用性。

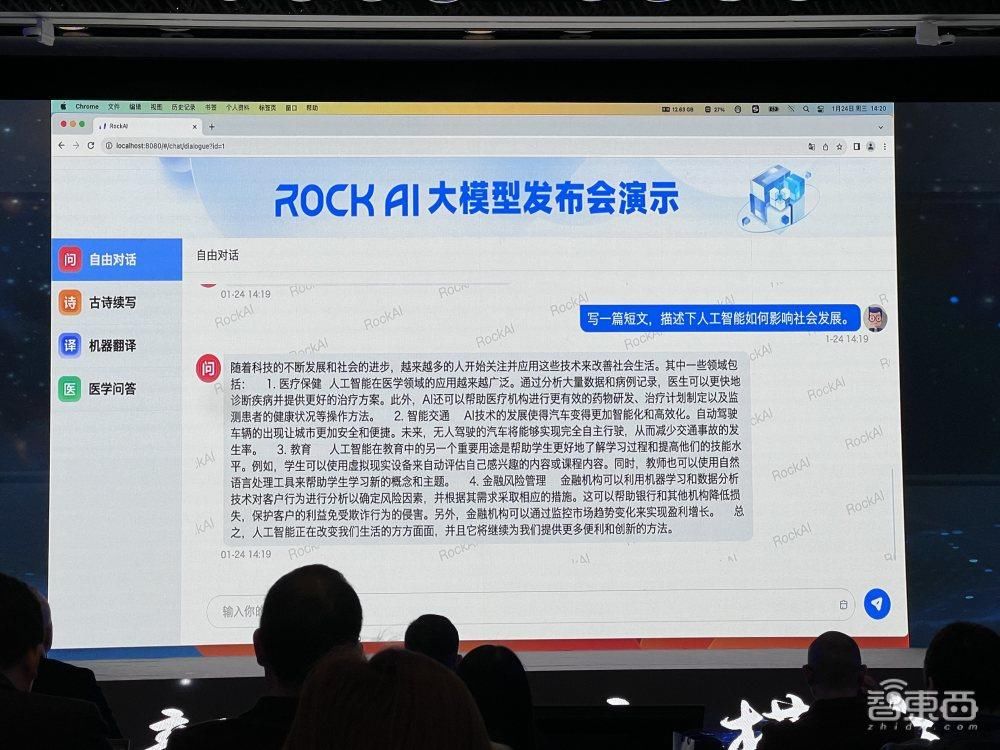

3、自由对话,能作诗能写文章

在自由对话方面,Yan1.0在现场演示创作了一首诗,描述春天百花齐放的场景。

而后,Yan1.0又被要求描述AI如何影响社会发展,它流畅地输出了200~300字的短文。

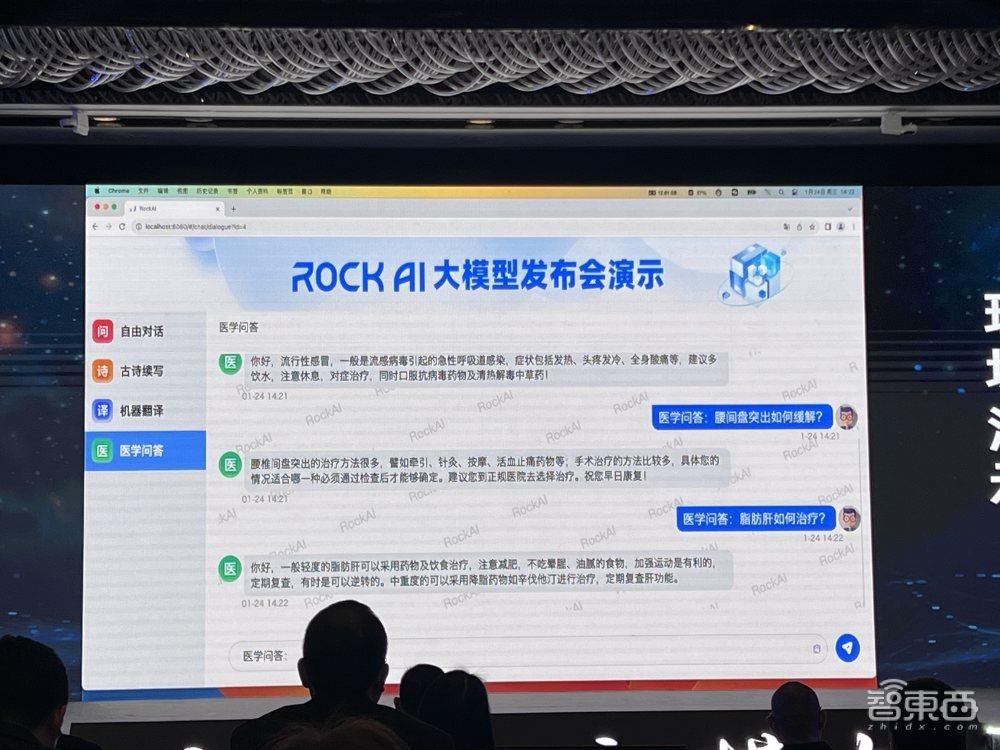

4、医学问答,提供健康助理建议

当被问到“流行性感冒如何缓解?”、“腰间盘突出如何缓解?”、“脂肪肝需要如何治疗?”等问题,Yan1.0都给出了建议。

三、超1000天三大迭代,Yan2.0将升级全模态

刘凡平说,Yan并不是团队研发的第一代模型,而是经过了1000多天三代迭代的成果。

Dolphin1.0是标准的Transformer架构,当时团队认为通用人工智能应该已经有了一个比较好的模型架构Transformer了,于是就基于Transformer去做了一套模型。

但在深入研究和实践之后发现缺陷:Transformer架构训练成本太高,成本难以覆盖客户给公司的付费,这种情况下一直做下去是做一单亏一单。团队一开始的解法是基于它加深研究。

所以有了Dolphin2.0。2.0出来之后,团队发现模型的交互还是有很多问题,包括引入线性的Attention机制也有很多问题。于是团队就两头走,一方面尝试改进Attention机制,另一方面尝试引进新的模型架构。

通过两条路探索,团队最终发现还是Yan架构有优势。但这个Yan是最后走出来的,此前团队还尝试了图架构、树形架构等多种路径。从图架构最开始出来的时候,只有部分功能比较好用;到后来树形记忆网络阶段,模型能克服幻觉,记忆能力更好,但推理能力却下降了,比如回答问题没有逻辑性。所以,最后才慢慢演化出了Yan架构。

面临算力耗费高、数据需求大等问题,因此岩芯数智从技术上放弃了Transformer架构和Attention机制。

刘凡平预告,岩芯数智第四代大模型Y2.0已经在路上,这是一个全模态的大模型架构,目标是要全面打通感知、认知、决策与行动,构建通用人工智能的智能循环。岩芯数智不是要复制一个Llama,或者做一个垂直大模型,而是要做一个通用人工智能操作系统。

后续在商业化方面,岩芯数智计划上接云计算、终端厂商等厂家,下接应用开发类厂商,促进其通用人工智能操作系统的落地。

结语:Transformer计算成本高,新模型架构引关注

随着大模型的爆火,传统的Transformer架构同时展现出计算复杂度高、成本压力大等问题,国际上已有Mamba、RWKV等非Transformer架构大模型引起关注,国内也诞生了Yan这样的新架构。

为了研发Yan架构,正如刘凡平所说,其团队经历了众多架构的尝试和迭代,最终取得了记忆、推理等多项能力提升。大模型底层技术的路线之争是一个长期演进过程,哪一条路线能真正跑赢,还需要在实践和与全球对手的比拼中得到验证。

","gnid":"99c338125ff235708","img_data":[{"flag":2,"img":[{"desc":"","height":"383","title":"","url":"https://p0.ssl.img.360kuai.com/t012beedaa8f80388de.jpg","width":"900"},{"desc":"","height":750,"title":"","url":"https://p0.ssl.img.360kuai.com/t0148500b6f8c6b8a4e.jpg","width":1000},{"desc":"","height":"387","title":"","url":"https://p0.ssl.img.360kuai.com/t01c67903b6dabb39eb.jpg","width":"1000"},{"desc":"","height":750,"title":"","url":"https://p0.ssl.img.360kuai.com/t01d0c69a6e2e085c5c.jpg","width":1000},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t0179b9de33c1a40803.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t01c7aed0c1f1e4b237.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t01ec22a9191912576e.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t015962243c53e56278.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t012e356ff9f34bc4c2.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t01cce3dbae64618301.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t01ef8070b217f34924.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t01318f4afa8e107e0e.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t01a407c711f1e258ff.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t0115c4cd4da70053db.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t01204427d7a950a302.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t016e13155da36c6975.jpg","width":"1000"},{"desc":"","height":"750","title":"","url":"https://p0.ssl.img.360kuai.com/t01a772f263c95007d8.jpg","width":"1000"}]}],"original":0,"pat":"art_src_3,fts0,sts0","powerby":"pika","pub_time":1706155200000,"pure":"","rawurl":"http://zm.news.so.com/6dec8a21757d464b48f7dddaa80e5db2","redirect":0,"rptid":"ed061c08876bec17","rss_ext":[],"s":"t","src":"智东西","tag":[],"title":"国内首个非Attention大模型发布!训练效率是Transformer的7倍

籍云柏4161求助英语高手帮我翻译:【一:CAUTION译成中文.二:AVERTISSEMNT三WARNUNG四AVISO五ATTENZIONE】谢谢! -

蒋婕急13545746439 ______ 1.CAUTION (caution)留神、注意——提醒方面用语2.ADVERTISEMENT (advertisment)广告、宣传——各种形式3.WARNING (warning)警示、警告——也是提醒方面用语4.AVISO (aviso)通报、通讯舰5.ATTENTION (attention)注意、专心——原字可能不是英文,但意思还应是这个意思. 写错的字我都改过,上面的英文字有很多解释,我无法一一列举,如果还有问题,请发追问过来.另外: 紫外线光源—— ultra-violet rays(light )source

籍云柏4161问两句英语~There are just too many things all demanding my attention at once.翻译为:那里有太多的事情需要我去处理.这里demand作为“需要”的意思,... -

蒋婕急13545746439 ______[答案] attention是注意力的意思 太多东西需要我去注意 或者需要我的注意力 demand有索取的意思 比较强烈 用ask for some money from my dad好点

籍云柏4161怎么用说英语关心别人 比如:要注意休息 -

蒋婕急13545746439 ______ 要注意休息_有道翻译 翻译结果:To pay attention to rest attention_有道词典 attention 英 [ə'tenʃ(ə)n] 美 [ə'tɛnʃən] n. 注意力;关心;立正!(口令) Attention 注意,注意力,关注 Pay Attention 注意对手,注意,关注 attention to 对,的注意,注意

籍云柏4161用attention名词形式造英语句并带翻译 -

蒋婕急13545746439 ______ Please pay more attention to your pronunciation. 请多注意你的发音.

籍云柏4161“看着我”翻译成英文 -

蒋婕急13545746439 ______ 一般就用:Look at me.正式场合用:Your attention,please.

籍云柏4161bring to our attention -

蒋婕急13545746439 ______ bring是带来的意思,所以bring to our attention可以翻译为吸引我们的注意

籍云柏4161连词成句 attention,we,studying,should,students,as,to,pay -

蒋婕急13545746439 ______ As students ,we should pay attention to studying .翻译:作为学生,zd我们应该注意学习.如果不明白,请再问;如果对你有所帮助,请点击版本页面中的“选为满权意回答”按钮,谢谢!

籍云柏4161翻译下这几个英语

蒋婕急13545746439 ______ 1.Please stop here. 2.No smoking is allow 3.Caution(pay attention to the safety) 1.Not in service是停止服务中的意思,所以不能用在第一句,但是你不是求意思的话,可以啊. 2.fire forbidden应该可以 3.我在街上很少看到attention,caution比较普遍把. 相交于利,利存于义,我不会翻译啊.

籍云柏4161用英语写含有draw,attention的句子,句子翻译过来意为:能吸引全球的注意 -

蒋婕急13545746439 ______[答案] can draw global attention.

籍云柏4161arrest the attention 可以翻译为吸引注意吗? -

蒋婕急13545746439 ______[答案] arrest the attention 逮捕的关注 翻译来自有道词典 仅供参考