求梯度公式

编辑导语:机器学习是策略产品经理需要了解的一个方面,而梯度下降法则是学习机器学习必须了解的思想,本文作者通过一个案例介绍了梯度下降法,一起来看一下吧。

策略产品经理必须要对机器学习有一定的了解,而梯度下降法则是学习机器学习必须要了解的思想,本篇通过一个生动的案例来为大家介绍到底什么是梯度下降法。

01 引入

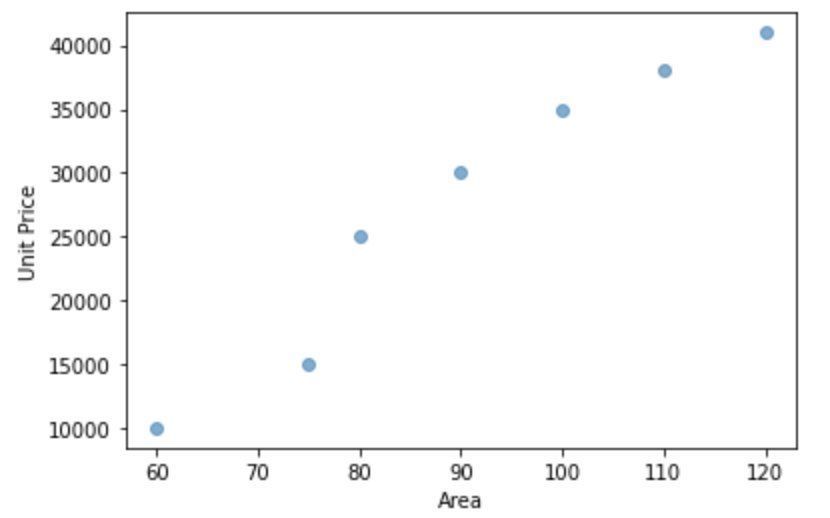

我们先从一个案例入手,下图是一组上海市静安区的房价信息:

我们用Python在坐标系上面画出来如下图:

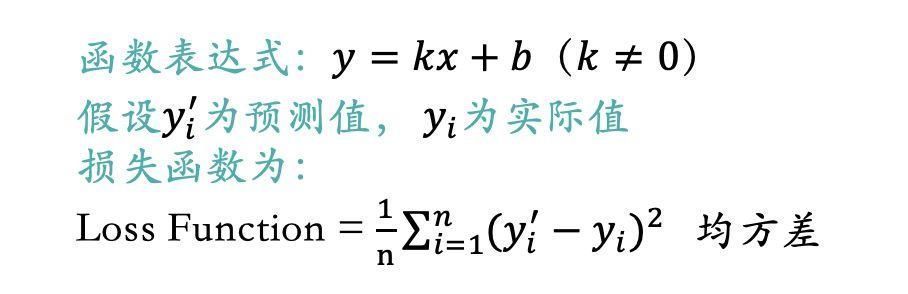

我们现在想拟合一个线性函数来表示房屋面积和房价的关系。我们初中都学过的一元一次函数表达式为:y=kx+b(k≠0)。很明显不可能有一对组合(k,b)全部经过上图7个点,我们只能尽可能地找到一对组合,使得该线性函数离上图7个点的总距离最近。

如上图所示,实际值与预测值之间差异的均方差我们把它称为损失函数,也有叫做成本函数或者代价函数的,意义都一样。我们希望找到一个组合(k,b)可以使得损失函数的值最小。

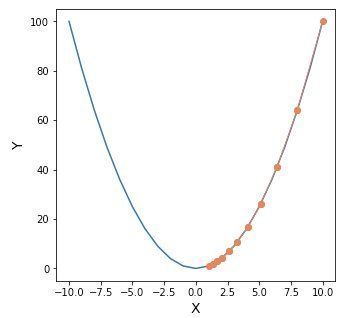

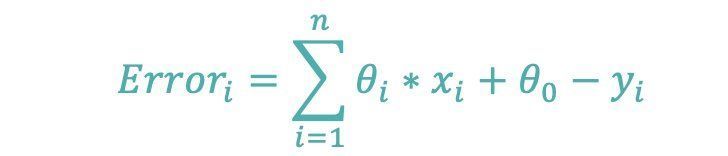

上述只有一个输入变量x,如果我们多加入几个输入变量,比如卧室的数量、离最近地铁站的距离。最终目标变量和损失函数我们用下述函数表达式来表达:

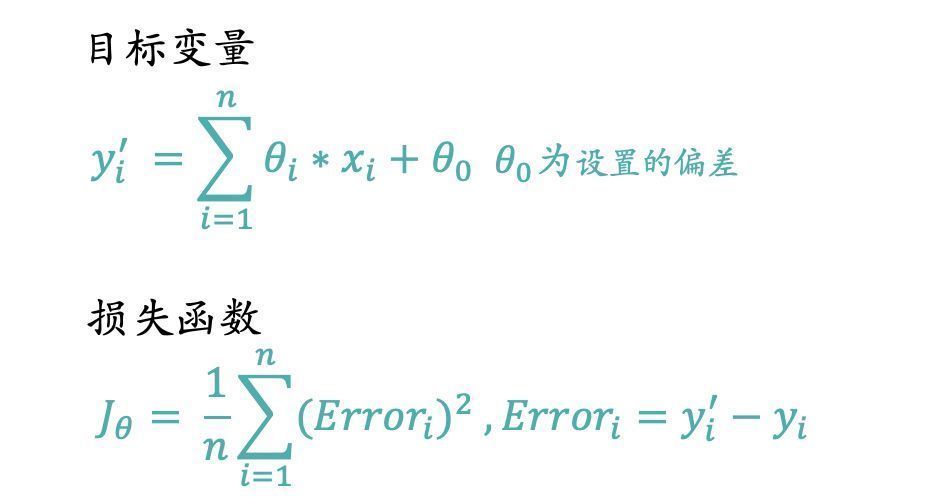

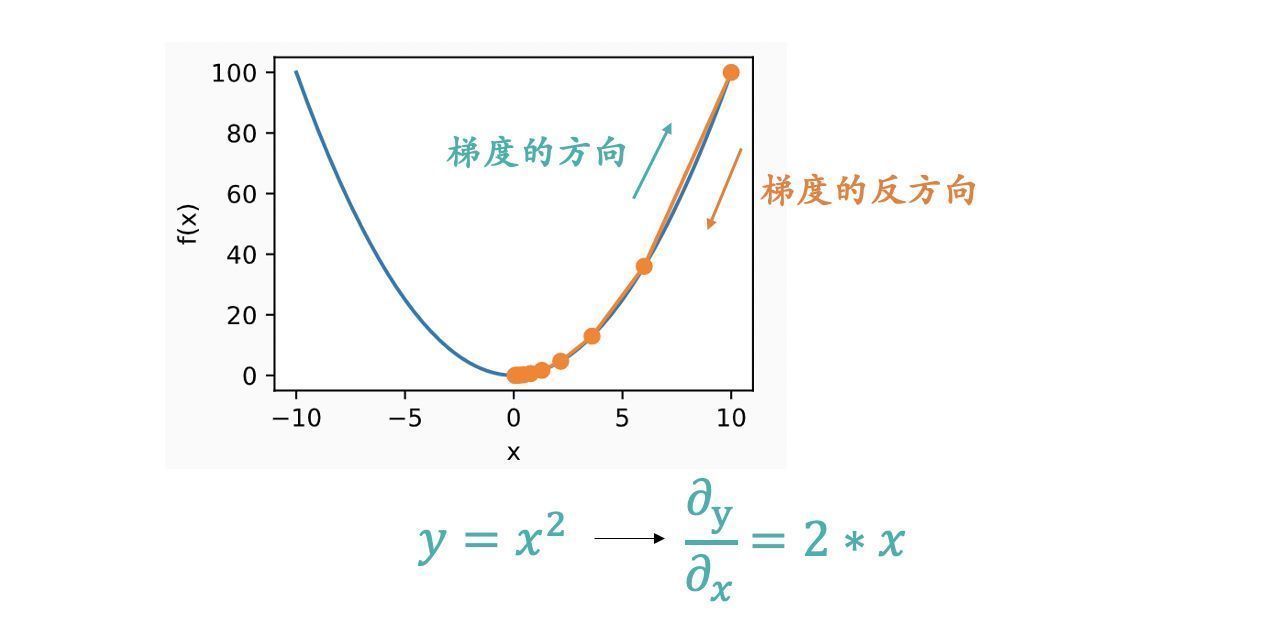

现在我们的任务就是求出一组θ,在已知【x,y】的前提下使得损失函数的值最小。那么如何计算出θ了,使用什么方法了?我们首先回到损失函数表达式本身,损失函数本身是一个y=x^2的形式,高中数学大家应该都学过这是一个开口向上的抛物线方程,大概长下图这样:

我们如何找到这个函数的最低点?上图是一个二维图,我们很轻松就可以肉眼看出x=0时,y最小。如果维度更多,比如z = (x-10)^2 + (y-10)^2,则得到下图:

我们如何定位出最小值,特别强调一点,这里的x是一个“大”参数的概念,x应该等于下述公式

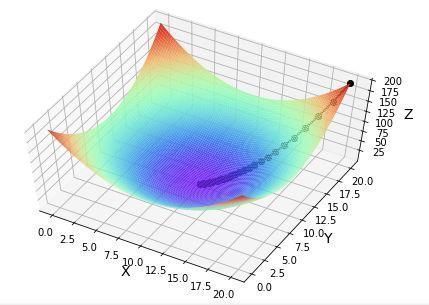

大家要明确上图横坐标是x和y,函数表达式里的θ已经知道了,所以我们是找到最合适的(x,y)使得函数值最小。如果我们现在是已知样本(x,y),那么上图的变量就变为了θ_0和θ_i,并不是x_i,我们是以θ_0和θ_i作为输入变量做的图,x_i和y_i都是已知的固定值,这一点必须明确了。上图的纵坐标的值就变为损失函数的值。

我们的问题是已知样本的坐标(x,y),来求解一组θ参数,使得损失函数的值最小。我们如何找到上图中的最低点?因为找到最低点,那么最低点对应的横坐标所有维度就是我们想得到的θ_0和θ_i,而纵坐标就是损失函数的最小值。找到最低点所有答案就全部解出来了。

现在问题来了?有没有一种算法让我们可以慢慢定位出最小值,这个算法就是梯度下降法。

02 梯度下降法简介

1. 梯度下降法的思想我们首先介绍梯度下降法的整体思想。假设你现在站在某个山峰的峰顶,你要在天黑前到达山峰的最低点,那里有食品水源供给站,可以进行能量补充。你不需要考虑下山的安全性,即使选择最陡峭的悬崖下山,你也可以全身而退,那么如何下山最快了?

最快的方法就是以当前的位置为基准,寻找该位置最陡峭的地方,然后沿该方向往下走。走一段距离后,再以当前位置为基准,重新寻找最陡峭的地方,一直重复最终我们就可以到达最低点。我们需要不停地去重新定位最陡峭的地方,这样才不会限于局部最优。

那么整个下山过程中我们会面临两个问题:

- 如何测量山峰的“陡峭”程度

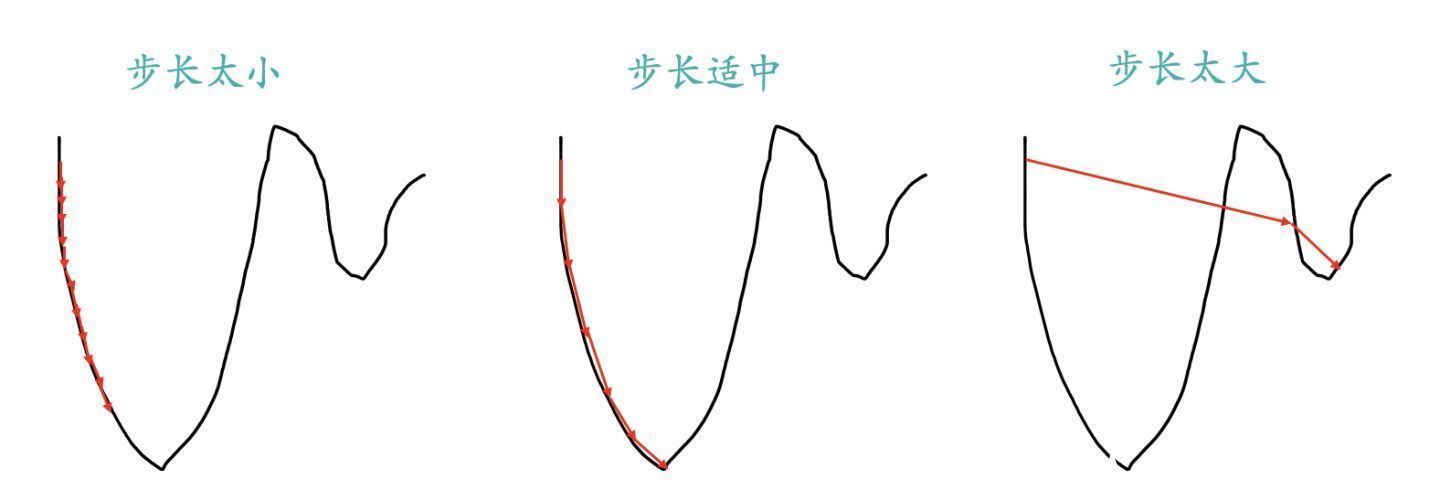

- 每一次走多长距离后重新进行陡峭程度测量;走太长,那么整体的测量次数就会比较少,可能会导致走的并不是最佳路线,错过了最低点。走太短,测量次数过于频繁,整体耗时太长,还没有到达食品供给站就已经GG了。这里的步长如何设置?

Part1里面介绍了如何从一个开口向上的抛物线高点定位到最低点的问题和下山的场景是完全类似的,抛物线就相当于一个山峰,我们的目标就是找到抛物线的最低点,也就是山底。

最快的下山方式就是找到当前位置最陡峭的方向,然后沿着此方向向下走,对应到抛物线中,就是计算给定点的梯度,然后朝着梯度相反的方向( Part 2.3里面会解释为什么是朝着梯度相反的方向),就能让抛物线值下降的最快。同时我们也要和下山一样,不停地定位新位置,再计算新位置的梯度,然后按照新方向下降,最后慢慢定位到抛物线的最低点。

2. 梯度下降法算法Part2.1里面已经介绍了梯度下降法的思想,遗留了两个问题。第一就是如何计算“陡峭”程度,我们这里把它叫做梯度,我们用∇J_θ来代替。第二个也就是步长问题,我们用一个α学习率来代表这个步长,α越大代表步长越大。知道了这两个值,我们如何去得到θ参数的更新表达式了?

J是关于θ的一个函数,假设初始时我们在θ_1这个位置,要从这个点走到J的最小值点,也就是山底。首先我们先确定前进的方向,也就是梯度的反向“-∇J_θ”,然后走一段距离的步长,也就是α,走完这个段步长,就到达了θ_2这个点了。表达式如下图:

我们按照上述表达式一直不停地更新θ的值,一直到θ收敛不变为止,当我们到达山底,此时函数的梯度就是0了,θ值也就不会再更新了,因为表达式的后半部分一直是0了。

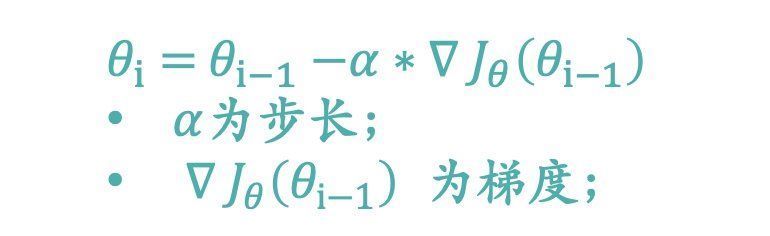

整个下降过程中损失函数的值是一定在减少,但是我们想学习出来的参数值θ不一定一直在减小。因为我们需要找到损失函数最小时的坐标点,这个坐标点的坐标不一定是原点,很可能是(2,3)甚至是(4,6),我们找到的是最合适的θ值使得损失函数最小。下图我们用一个例子来进行说明:

上图的最低点很明显就是原点,我们通过梯度下降法来逼近这个最低点。我们可以看到损失函数的值在一直减少,θ的值也在往0这个值进行收敛。

3. 梯度下降法数学计算Part1和2介绍了梯度下降的思想和θ更新的表达式,现在我们从数学层面进行解释:

1)为什么是向梯度相反的方向下降

上图应该很形象地显示为什么要朝着梯度的反方向了。梯度是一个向量,梯度的方向是函数在指定点上升最快的方向,那么梯度的反方向自然是下降最快的方向了。

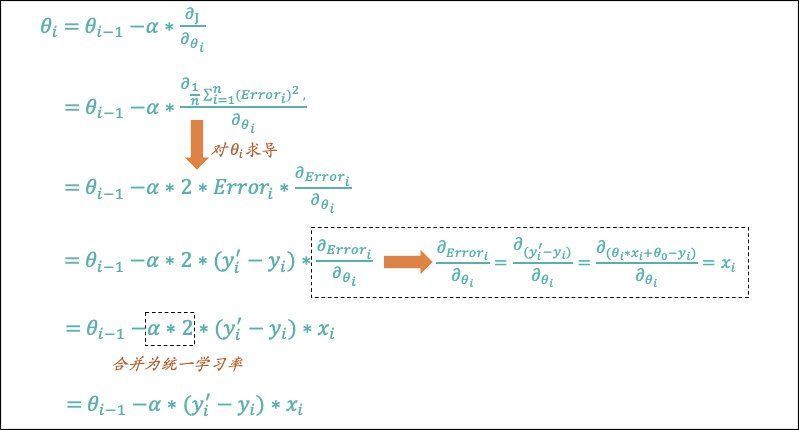

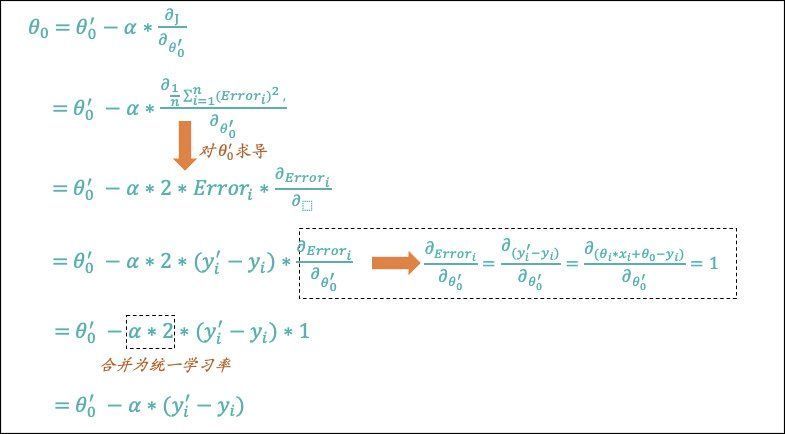

2)泛化的θ参数更新公式

Part2.2里面的例子我们选择的是一个最简单的函数表达式,θ参数分为两种,一种是和输入变量x配对的参数θ_i,一种是固定的偏差θ_0。我们用已知的样本数据(x,y)来求解出使得损失函数最小的一组θ参数。下面我们来计算一个通用泛化的θ参数更新表达式。我们只需要用到高中数学中的导数知识即可,朋友们相信我真的很easy。

下图是对和输入变量x配对的参数θ_i更新表达式:

下图是对固定的偏差θ_0的更新表达式:

上面的数学过程也就是高中我们学习导数里面最简单的求导过程了。那么至此我们也就将梯度下降算法的思想和数学解释全部介绍完了。

4. 梯度下降法分类Part2.3里面的公式大家也看到了我们要借助样本的(x,y)的数据来进行参数θ的更新,如果现在样本有100条数据,我们如何来更新。正常情况下,我们更新的方式有两种:

1)随机梯度下降(Stochastic Gradient Descent)

我们每次只使用单个训练样本来更新θ参数,依次遍历训练集,而不是一次更新中考虑所有的样本。就像开头介绍那7条房价数据,我们一个一个来计算,计算一次更新一次θ,直到θ收敛或者达到后期更新幅度已经小于我们设置的阀值。

2)批量梯度下降(Batch Gradient Descent)

我们每次更新都遍历训练集中所有的样本,以它们的预测误差之和为依据更新。我们会一次性将7条样本数据的预测误差都汇总,然后进行一次更新。更新完以后,继续以7条样本数据的预测误差之和进行汇总,再更新,直到θ收敛或者达到后期更新幅度已经小于我们设置的阀值。

当训练样本数很大时,批量梯度下降的每次更新都会是计算量很大的操作,而随机梯度下降可以利用单个训练样本立即更新,因此随机梯度下降 通常是一个更快的方法。但随机梯度下降也有一个缺点,那就是θ可能不会收敛,而是在最小值附近振荡,但在实际中也都会得到一个足够好的近似。

所以实际情况下,我们一般不用固定的学习率,而是让它随着算法的运行逐渐减小到零,也就是在接近“山底”的时候慢慢减小下降的“步幅”,换成用“小碎步”走,这样它就更容易收敛于全局最小值而不是围绕它振荡了。

03 梯度下降法Python实践

以下就是通过实际运行程序得到的相关结果图。

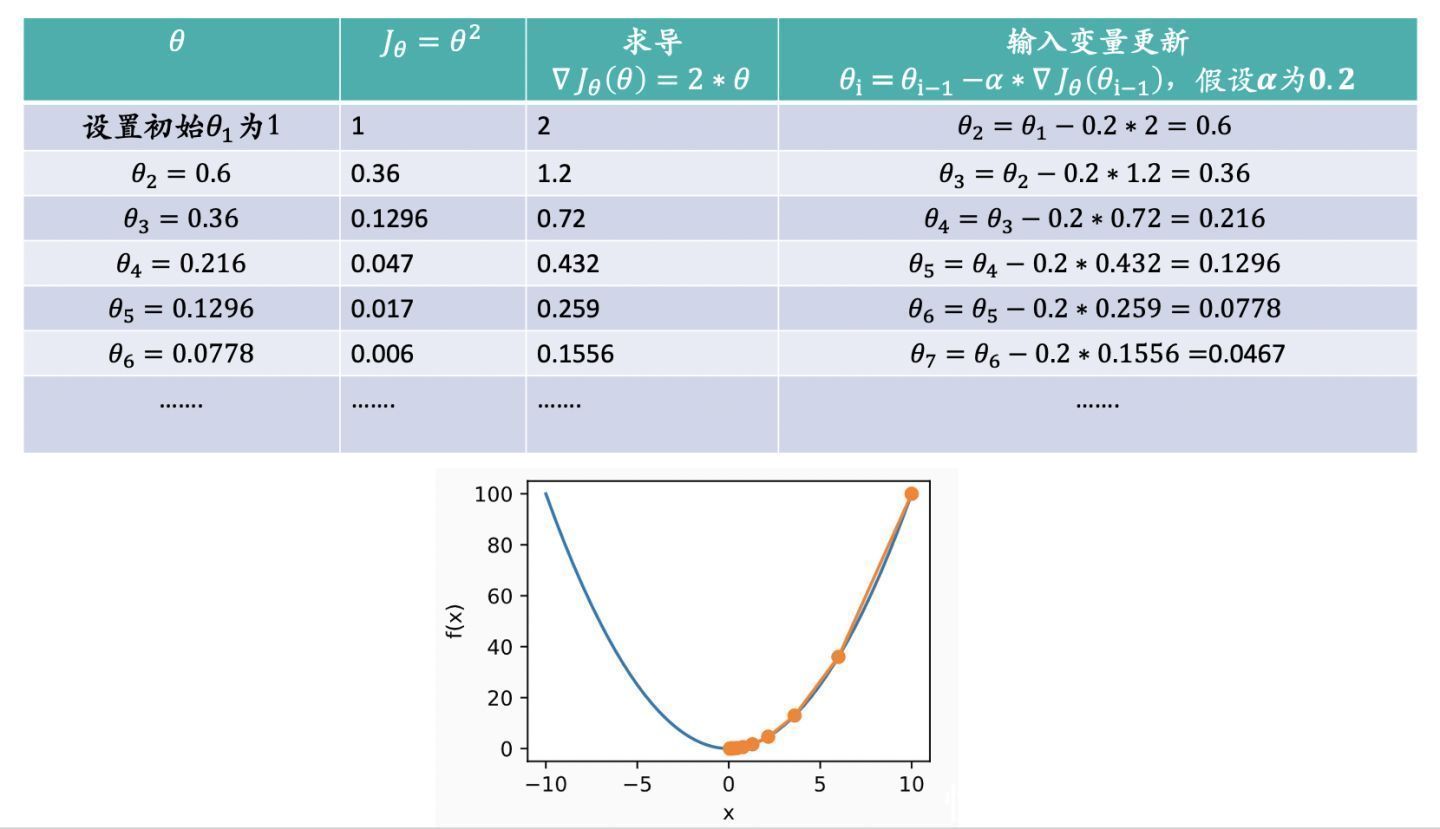

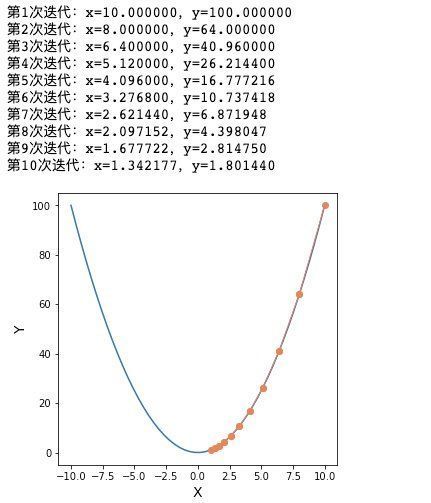

1. 单变量:y = x^2求最低点假设X的初始值是10,我们让程序迭代10次得到的结果如下图:

2. 多变量:z = (x-10)^2 + (y-10)^2求最低点

2. 多变量:z = (x-10)^2 + (y-10)^2求最低点假设X和Y的初始值都是20,我们让模型迭代100次得到的效果如下图:

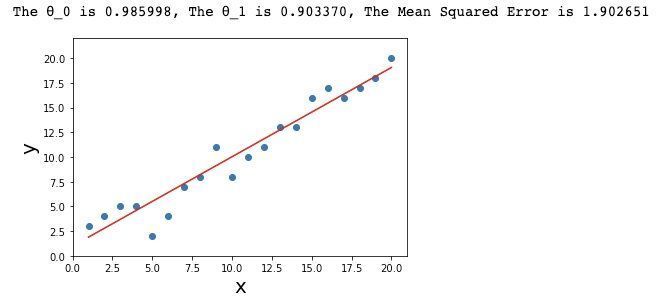

3. 根据给定样本求解出最佳θ组合

3. 根据给定样本求解出最佳θ组合假设样本中X和Y的值如下:

x = [1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16,17,18,19,20]

y = [3,4,5,5,2,4,7,8,11,8,10,11,13,13,16,17,16,17,18,20]

我们希望找到一组参数θ_0和θ_1来拟合一个X和Y之间的最优线性模型,最终拟合结果如下:

本篇文章前半部分通俗易懂地将整个梯度下降算法全面地讲解了一遍,后半部分通过Python实际落地了各种案例,希望看完后大家对于梯度下降法有一个全面且具象的了解。

本文由 @King James 原创发布于人人都是产品经理。未经许可,禁止转载。

题图来自 Unsplash,基于 CC0 协议

","force_purephv":"0","gnid":"995d0499c000bd70c","img_data":[{"flag":2,"img":[{"desc":"","height":"420","title":"","url":"https://p0.ssl.img.360kuai.com/t01cccc5521e7c28b5e.jpg","width":"900"},{"desc":"","height":"280","title":"","url":"https://p0.ssl.img.360kuai.com/t01a1b35479d50f0534.jpg","width":"270"},{"desc":"","height":"518","title":"","url":"https://p0.ssl.img.360kuai.com/t01453c7487d0fa7f27.jpg","width":"830"},{"desc":"","height":"294","title":"","url":"https://p0.ssl.img.360kuai.com/t01e5b9fcac61dc70a8.jpg","width":"908"},{"desc":"","height":"498","title":"","url":"https://p0.ssl.img.360kuai.com/t019b1c4a33f722043b.jpg","width":"936"},{"desc":"","height":"318","title":"","url":"https://p0.ssl.img.360kuai.com/t015ca72b5fdf148089.jpg","width":"348"},{"desc":"","height":"305","title":"","url":"https://p0.ssl.img.360kuai.com/t0192d1750e54c7a4e1.jpg","width":"418"},{"desc":"","height":"156","title":"","url":"https://p0.ssl.img.360kuai.com/t018010e455326b70cc.jpg","width":"728"},{"desc":"","height":"680","title":"","url":"https://p0.ssl.img.360kuai.com/t010aa7fc41549e9d24.jpg","width":"1440"},{"desc":"","height":"490","title":"","url":"https://p0.ssl.img.360kuai.com/t0162dd3490c31c1b4d.jpg","width":"1440"},{"desc":"","height":"236","title":"","url":"https://p0.ssl.img.360kuai.com/t0174a8e72f5935e611.jpg","width":"770"},{"desc":"","height":"829","title":"","url":"https://p0.ssl.img.360kuai.com/t015f5c7c0aab78163c.jpg","width":"1440"},{"desc":"","height":"628","title":"","url":"https://p0.ssl.img.360kuai.com/t01cb3598b882af351c.jpg","width":"1264"},{"desc":"","height":"430","title":"","url":"https://p0.ssl.img.360kuai.com/t01c78b85f988d6a736.jpg","width":"799"},{"desc":"","height":"434","title":"","url":"https://p0.ssl.img.360kuai.com/t0108afde52b63db8bb.jpg","width":"785"},{"desc":"","height":"503","title":"","url":"https://p0.ssl.img.360kuai.com/t0152d3450d114e1348.jpg","width":"431"},{"desc":"","height":"305","title":"","url":"https://p0.ssl.img.360kuai.com/t013251bb39d354eebb.jpg","width":"429"},{"desc":"","height":"303","title":"","url":"https://p0.ssl.img.360kuai.com/t01e676adad7f6f03b4.jpg","width":"665"}]}],"original":0,"pat":"art_src_3,fts0,sts0","powerby":"hbase","pub_time":1659860400000,"pure":"","rawurl":"http://zm.news.so.com/d82dececde0b0186252d573631184ad4","redirect":0,"rptid":"6470f9c3776c7f0c","s":"t","src":"人人都是产品经理","tag":[],"title":"策略产品经理必读系列-梯度下降法

封骆竿4433什么是数学意义上梯度?如何计算?

宗伏秒17325332719 ______ 一个n元函数y=f(x1,x2,…,xn),y对第k个自变量的偏导数作向量第k个坐标,这样得到的向量,称为函数y的梯度,记作grad(y).

封骆竿4433极坐标中梯度公式的推导想知道在对角度求偏导的前面为什么多了个 r分之一呢,想知道整个公式的推导过程 -

宗伏秒17325332719 ______[答案] 利用坐标变换公式直接把直角坐标系的梯度公式变换为积坐标系中就是如此形式.关于这个角度或其他变量前的这种类似系数的东西,其本质的解释就是,每个空间(不同的坐标系)有其各自的度规,三维直角坐标系或笛卡尔空间的度规是3*3的单位...

封骆竿4433极坐标中梯度公式的推导 -

宗伏秒17325332719 ______ 利用坐标变换公式直接把直角坐标系的梯度公式变换为积坐标系中就是如此形式.关于这个角度或其他变量前的这种类似系数的东西,其本质的解释就是,每个空间(不同的坐标系)有其各自的度规,三维直角坐标系或笛卡尔空间的度规是3*3的单位矩阵,对角线上的数值对应梯度中各变量前的系数.

封骆竿4433高等数学梯度的问题?取曲线的梯度为例,如果曲线的方程是参数方程:x=x(t),y=y(t),那它的梯度该怎么求啊?求解,小弟十分疑惑. -

宗伏秒17325332719 ______[答案] 二维曲线只有两个参量,但是参数型二维曲线只有一个参量 所以按照梯度的要求 假设y=y(x) 即y(x)-y=0 那么梯度为 (y',-1) 由于y'=(dy/dt) /(dx/dt) 求得梯度为((dy/dt) /(dx/dt),-1)或者((dy/dt),-(dx/dt)) 三维的类推

封骆竿4433偏导数不存在,如何求梯度向量 -

宗伏秒17325332719 ______ 梯度向量就是gradf(x,y)=[∂f(x,y)/∂x]i+[∂f(x,y)/∂y)]j其实就是偏导在某点构成的向量,就是这个点的梯度向量. 设函数f(x,y)在平面区域D内具有一阶连续偏导数,则对于每一点P0(x0,y0)∈D,有梯度向量 所以不可导.没有梯偏导数不存在,如何求梯度向量

封骆竿4433梯度的求解

宗伏秒17325332719 ______ ∇=∂u/∂xi+∂u/∂yj+∂u/∂zk=(2x+3)i+(4y-2)j+(6z-6)k梯度的模为 =[(2x+3)^2+(4y-2)^2+(6z-6)^2]^0.5梯度模的平方 =(2x+3)^2+(4y-2)^2+(6z-6)^2

封骆竿4433求函数0=x+y+z的梯度 -

宗伏秒17325332719 ______[答案] grad[z(x,y)]=(∂z/∂x)*i+(∂z/∂y)*j =-(Fx/Fz)*i+[-(Fy/Fz)*j] =-i+(-j) =-(i+j)

封骆竿4433MATLAB编程求梯度 -

宗伏秒17325332719 ______ x=[]; m=[]; for i=1:24 sx=['x',num2str(i)]; sm=['m',num2str(i)]; eval(['syms ',sx,' ',sm]) eval(['x=[x,',sx,'];']); eval(['m=[m,',sm,'];']); end sh=sum(x.^2)/2*1e6; y=0; for i=1:length(x) y=y+sum(x(1:i)); sh=sh+(y-sum(x(1:i))/2)^2*m(i); end jac=jacobian(sh,x); jac'

封骆竿4433函数f(x,y)=arctanxy在点(0,1)处的梯度等于( )A.iB. - iC.jD. - -

宗伏秒17325332719 ______ 根据梯度的概念有:gradf(x,y)=?f ?x i +?f ?y j 因此本题转换为求?f ?x 和?f ?y 的值.?f ?x =? ?x arctan x y =1 1+( x y )2 1 y = y x2+y2 ?f ?y =? ?y arctan x y =1 1+( x y )2 (?x y2 )=?x x2+y2 当(x,y)=(0,1)时,有:?f ?x =1,?f ?y =0 代入梯度公式得:gradf|(0,1))=?f ?x i +?f ?y j = i 故本题因选:A.

封骆竿4433已知函数,怎么求梯度.已知梯度怎么求函数. -

宗伏秒17325332719 ______ 函数的偏导数组成的向量即梯度 已知梯度求原函数 可参见:格林公式那章.